Pārsteigums: Facebook saka, ka Facebook A-OK for News!

Vienīgā problēma? Tas ir Facebook pētījums, ko veikuši cilvēki, kuri strādā Facebook.

Vai tiešām mums visiem vajadzētu būt pārsteigtiem, ka paši Facebook pētnieki samazina līdz minimumam to, kā viņu kompānija manipulē ar cilvēku ziņu plūsmām?

Pētījums, Iedarbība uz ideoloģiski daudzveidīgām ziņām un viedokļiem vietnē Facebook, autors Eitans Bakšijs un kolēģi vietnē Facebook tika publicēti pagājušajā nedēļā Zinātne. Kā šo pētījumu varētu publicēt prestižajā žurnālā Zinātne? 1 Vai nav jāveic salīdzinošā pārskatīšana, lai piesaistītu pašnodarbinātus pētījumus, ko publicējuši uzņēmumi, kas tikai parāda to, ko uzņēmums vēlas, lai dati parāda?

Ir jābrīnās, kā salīdzinošie recenzenti izturēja šo publicēto pētījumu. Daudzas kritikas par pētījumu jau ir publicētas, tāpēc es vienkārši ātri apkopošu citu minētās problēmas. Šī Christian Sandvig kritika diezgan lielā mērā apkopo problēmu ar to, kā Facebook pētnieki savos secinājumos publicētajā pētījumā:

Par salīdzinājumu tēmu pētījums turpina teikt, ka:

"Mēs pārliecinoši nosakām, ka ... individuālas izvēles iespējas vairāk nekā algoritmi ierobežo attieksmi izaicinoša satura iedarbību."

"Salīdzinot ar algoritmisko rangu, indivīdu izvēlei par to, ko lietot, bija spēcīgāka ietekme"

Man zvana trauksmes zvani. Tabakas rūpniecība, iespējams, kādreiz ir finansējusi pētījumu, kurā teikts, ka smēķēšana ir mazāk bīstama nekā ogļu ieguve, taču šeit mums ir pētījums par ogļraču smēķēšanu. Iespējams, kamēr viņi atrodas ogļu raktuvēs.

Es gribu teikt, ka nav scenārija, kurā “lietotāja izvēli” pret “algoritmu” varētu tirgot, jo tas notiek kopā […]. Lietotāji izvēlas to, ko viņiem jau filtrēja algoritms. Tā ir secība.

Es domāju, ka pareizs apgalvojums par šīm divām lietām ir tas, ka viņi abi ir slikti - tie abi palielina polarizāciju un selektivitāti. Kā jau teicu iepriekš, šķiet, ka algoritms nedaudz palielina lietotāju selektivitāti.

Patiešām, jūs domājat, ka Facebook pētnieki, kuri, jūs zināt, strādā Facebook, saprot, ka jūs nevarat izķemmēt un nošķirt algoritmu no lietotāja uzvedības, jo viens ir atkarīgs no otra. Neveicot manipulācijas ar algoritmu (kuru Facebook pētījums, kuru atklāja Adams Kramers, nav laba lieta, ja vispirms neiegūstat lietotāja informētu piekrišanu), jūs īsti nevarat pateikt, kāpēc lietotāji noklikšķina uz vienas lietas vairāk nekā uz kaut ko citu.

Bet šis Zeynep Tufekci, Ziemeļkarolīnas Universitātes Chapel Hill profesora Zeynepa Tufekci pārskats rakstīja, ka pētījuma dati, kas patiešām tika atrasti, tika apglabāti pētījuma pielikumā:

Jo augstāka saite, jo vairāk (daudz vairāk) iespējams, ka uz tās tiks noklikšķināts. Jūs dzīvojat un mirstat pēc izvietojuma, ko nosaka ziņu plūsmas algoritms. (Efekts, kā pareizi atzīmē Šons Dž. Teilors, ir izvietojuma kombinācija un fakts, ka algoritms uzmin, ko jūs vēlētos).

Tas jau bija zināms, galvenokārt, taču ir lieliski, ka to apstiprina Facebook pētnieki (pētījuma autori ir tikai Facebook darbinieki). […]

Viens no jaunajiem atklājumiem ir tāds, ka ziņu plūsmas algoritms (nedaudz) nomāc daudzveidīgu saturu, un vēl viens būtisks un arī jauns atklājums ir tāds, ka izvietojums plūsmā (ļoti) ietekmē klikšķu skaitu.

Facebook parāda jums ziņas, kuras jūs, visticamāk, lasīsit (jo tas saskan ar jūsu politisko viedokli) un ka jo augstāk tās parādās jūsu ziņu plūsmā, jo lielāka iespējamība, ka jūs uz tās noklikšķināsiet.

Citiem vārdiem sakot, Facebook manipulācijas ar jūsu ziņu plūsmu joprojām ir svarīgs faktors, lai noteiktu, uz ko jūs, iespējams, noklikšķiniet. Un viņi turpina manipulēt ar šo plūsmu, lai parādītu jums politiski saskaņotus ziņu stāstus, nekā tad, ja viņu algoritmā nebūtu neobjektivitātes.

Un, kā Tufekci svarīgi atzīmēt, šī bija niecīga, izvēlēta Facebook lietotāju grupa, kuru pētīja tikai tāpēc, ka Facebook pētniekiem bija ērtāk (un lētāk) viņus izpētīt. Viņi apskatīja tikai tos lietotājus, kuri Facebook identificēja savu politisko piederību un regulāri piesakās pakalpojumā (aptuveni 4 procenti no visiem Facebook lietotājiem [tikai 9 procenti lietotāju deklarē savu politisko piederību Facebook, tas nozīmē, ka tas nav paraugs, kuru varat vispārināt) jebko no]). Tas neko nepasaka par Facebook lietotājiem, kuri nedeklarē savu politisko piederību Facebook - kas ir lielākā daļa no mums.

Vai Facebook varēja veikt stingrāku pētījumu? Protams, bet tam būtu vajadzīgas tradicionālākas izpētes metodes, piemēram, aptaujas pieņemšana vietnē kopā ar nejaušinātu atlasi pa e-pastu ārpus vietnes.

Tātad, šeit ir nefiltrēts, objektīvs secinājums no datiem (ar Tufekci pieklājību), ka Facebook pētnieki šķietami vērpās, sakot, ka tas, ko redzat viņu ziņu plūsmā, nav viņu vaina:

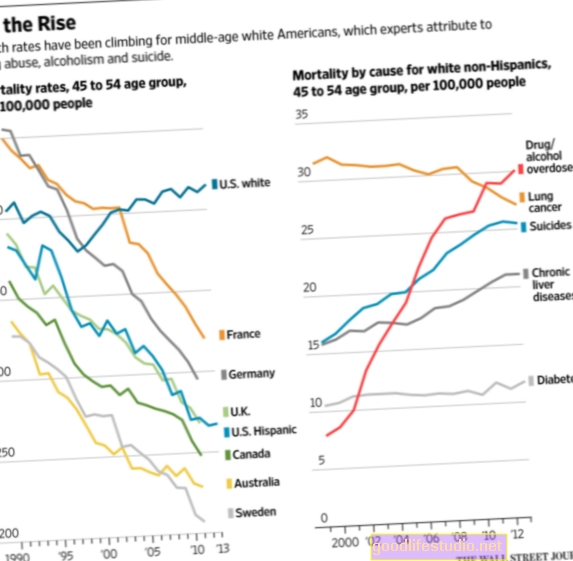

Facebook pētnieki pārliecinoši parāda, ka Facebook ziņu plūsmas algoritms samazina idejiski daudzveidīgu, transversālu saturu, ko cilvēki redz no saviem sociālajiem tīkliem Facebook par izmērāmu daudzumu. Pētnieki ziņo, ka daudzveidīga satura iedarbību ar Facebook algoritmu nomāc 8% pašidentificētiem liberāļiem un 5% pašidentificētiem konservatīviem.

Vai arī, kā saka Kristians Sandvigs, “algoritms filtrē 1 no 20 transversālām smagām ziņām, kuras redz pats sevi identificējis konservatīvs (jeb 5%), un 1 no 13 transversālām smagām ziņām, ko pats identificējis liberālis. redz (8%). ” Jūs redzat mazāk ziņu, kurām jūs nepiekritīsit un kuras draugi kopīgos, jo algoritms jums tās nerāda.

Diemžēl ārpus Ņujorkas Laiks un dažas citas tirdzniecības vietas, lielākā daļa galveno ziņu mediju vietņu tikko bez skepses ziņoja par to, ko Facebook pētnieki apgalvoja savā pētījumā.

Bet tagad jūs zināt patiesību - Facebook pētīja nelielu, nepārstāvošu paraugu, pēc tam mazināja to, ko viņu dati patiesībā parādīja, lai uzsvērtu pozitīvāku rezultātu attiecībā uz uzņēmumu. Man tas ir vēl viens piemērs, kad Facebook pētnieki īsti nesaprot zinātnisko pētījumu jēgu - dalīties ar pasauli ar zināšanām, kas nav tendenciozas un manipulētas.

Plašākai lasīšanai ...

Zeineps Tufekci: kā Facebook algoritms nomāc satura daudzveidību (pieticīgi) un kā ziņu plūsma nosaka jūsu klikšķus

Kristians Sandvigs: Facebook pētījums “Tā nav mūsu vaina”

NY Times: Facebook izmantot polarizāciju? Vietne sāk atšķirties

Zemsvītras piezīmes:

- Diemžēl man tagad ir jāpievieno vēl viens žurnāls savam cienījamo zinātnisko publikāciju sarakstam, kas vēl jāpārbauda. Kā zina ilggadējie Psiholoģijas pasaules lasītāji, šis saraksts katru gadu kļūst garāks: Pediatrija (Pediatrija publicē pētījumus par tehnoloģijām, kurus acīmredzot pārskata neviens, kurš nepārzina fundamentālo pētījumu cēloņsakarības.), Kiberpsiholoģija, uzvedība un sociālie tīkli (Kiberpsiholoģija acīmredzot publicē jebkuru pētījumu par atkarību no interneta vai sociālajiem tīkliem neatkarīgi no tā kvalitātes.) Un tagad, Zinātne. [↩]