Izstrādē: viedtālruņi, kas var novērtēt garastāvokli

Programmā netiek analizēts, ko cilvēks saka, bet gan kā.

"Mēs faktiski izmantojām aktieru ierakstus, kuri nolasīja mēneša datumu - patiesībā nav svarīgi, ko viņi saka, bet tas, kā viņi to saka, mūs interesē," sacīja profesore Wendi Heinzelmana. elektrotehnikas un datortehnikas jomā.

Programma analizē 12 runas iezīmes, piemēram, skaņas augstumu un skaļumu, lai noteiktu skaņas ierakstā vienu no sešām emocijām. Pētnieki apgalvo, ka tā sasniedz 81 procentu precizitāti, kas ir būtisks uzlabojums salīdzinājumā ar iepriekšējiem pētījumiem, kas sasniedza tikai aptuveni 55 procentu precizitāti.

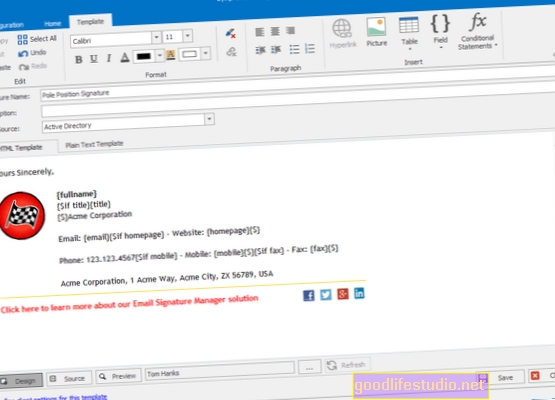

Pētījums jau ir izmantots, lai izstrādātu lietotnes prototipu, kas parāda vai nu laimīgu, vai skumju seju pēc lietotāja balss ierakstīšanas un analīzes. To uzcēla viens no Heinzelmana maģistrantiem Na Yang, vasaras prakses laikā Microsoft Research.

"Pētījums joprojām ir sākumstadijā," atzina Heinzelmans, "taču ir viegli iedomāties sarežģītāku lietotni, kas varētu izmantot šo tehnoloģiju visam, sākot no jūsu mobilajā tālrunī (tālrunī) redzamo krāsu pielāgošanas līdz mūzikas atskaņošanai atbilstoši jūsu viedoklim. pēc balss ierakstīšanas jūtos. ”

Heinzelmana un viņas komanda sadarbojas ar Ročesteras psihologiem Dr. Melisa Stērža-Apple un Patriks Deivijs, kuri šobrīd pēta pusaudžu un viņu vecāku mijiedarbību. "Uzticams veids, kā klasificēt emocijas, varētu būt ļoti noderīgs mūsu pētījumos," sacīja Stērdžs-Ābols. "Tas nozīmētu, ka pētniekam nav jāuzklausa sarunas un manuāli jāievada dažādu cilvēku emocijas dažādos posmos."

Mācīt datoru, lai saprastu emocijas, vispirms jāsaprot, kā cilvēki to dara, norāda pētnieki.

"Jūs varētu dzirdēt kādu runājam un domājam:" Ak, viņš izklausās dusmīgs. "Bet kas tev liek tā domāt?" teica Sturge-Apple.

Viņa paskaidroja, ka emocijas ietekmē cilvēku runas veidu, mainot runas skaļumu, augstumu un pat harmoniku. "Mēs nepievēršam uzmanību šīm funkcijām atsevišķi, mēs tikko esam iemācījušies, kā izklausās dusmīgi, it īpaši cilvēkiem, kurus mēs pazīstam," viņa piebilda.

Bet, lai dators kategorizētu emocijas, tam jāstrādā ar izmērāmiem lielumiem. Tātad pētnieki izveidoja 12 specifiskas runas iezīmes, kas katrā ierakstā tika mērītas ar nelieliem intervāliem. Pēc tam pētnieki klasificēja katru ierakstu un izmantoja tos, lai datorprogrammai iemācītu, kā izklausās “skumji”, “laimīgi”, “bailīgi”, “riebīgi” vai “neitrāli”.

Pēc tam sistēma analizēja jaunus ierakstus un mēģināja noteikt, vai balss ierakstā atspoguļo kādu no zināmajām emocijām. Ja datorprogramma nespēja izšķirties starp divām vai vairāk emocijām, tā vienkārši atstāja šo ierakstu neklasificētu.

"Mēs vēlamies būt pārliecināti, ka tad, kad dators domā, ka ierakstītā runa atspoguļo konkrētas emocijas, ir ļoti iespējams, ka tas patiešām atspoguļo šīs emocijas," sacīja Heinzelmans.

Iepriekšējie pētījumi ir parādījuši, ka emociju klasifikācijas sistēmas ir ļoti atkarīgas no runātāja, tas nozīmē, ka tās darbojas daudz labāk, ja sistēmu apmāca tā pati balss, kuru tā analizēs. "Tas nav ideāli situācijā, kad vēlaties, lai jūs varētu vienkārši veikt eksperimentu ar cilvēku grupu, kas runā un mijiedarbojas, piemēram, vecākiem un pusaudžiem, ar kuriem mēs strādājam," sacīja Stērge-Apple.

Jaunie rezultāti apstiprina šo secinājumu. Ja uz runu balstītu emociju klasifikāciju izmanto balsij, kas atšķiras no tās, kas apmācīja sistēmu, precizitāte samazinājās no 81 procentiem līdz aptuveni 30 procentiem. Pētnieki tagad meklē veidus, kā samazināt šo efektu, apmācot sistēmu ar balsi tajā pašā vecuma grupā un tajā pašā dzimumā.

"Joprojām ir jāatrisina problēmas, ja mēs vēlamies izmantot šo sistēmu vidē, kas līdzinās reālajai situācijai, taču mēs zinām, ka mūsu izstrādātais algoritms ir efektīvāks nekā iepriekšējie mēģinājumi," sacīja Heinzelmans.

Avots: Ročesteras universitāte